そこ曲がったら、量子坂?(上り) Appendix2

量子優位性に関する論文の発表が相次いでいる(33|、Appendix 14、❚ちょい足し❚)と認識している。そのトレンドに沿ったというわけでもないだろうが、グーグル量子AIの研究者は、量子優位性に関するポジション・ペーパー(以下、本PP[*A-77])を発表した(25年11月14日@arXiv)。本PPの内容を、煽情的かつ標語的に言えば、「絶望を越えて行け」であろうか。他論文に比べて、「実用的な量子優位性の実現困難性に踏み込んでいる」と感じる。この内容はアカデミアの研究者だけでは書けない。さすが、グーグルといったところであろうか。

なお、本PPでは、量子優位性(advantage(s))と量子高速化(speed-up)は、明確に区別されている。量子「優位性」は、古典アルゴリズムよりも少ない計算資源しか必要としない規模で実行される場合に限定して、使用される。量子「高速化」は単に、アルゴリズムのスケーリング(計算速度の加速)を指す。さらに改めて、実用的な量子優位性を達成するには、2次加速を超える高速化=超2次加速が必要である、と表明している。

【1】本PPの構成

本PPは、(1)の観点から(2)の導入を提示し、(3)~(7)を主張する:

(1) 理論上の量子アルゴリズムから、実用的な量子アプリケーションへ至る道のりは、長く複雑な取り組みである。

(2) 量子アプリケーション研究の成熟度を分類・理解し、実用的な量子アプリケーション実現への道筋における「主要なボトルネックを特定することを目的」とする5段階🐾1フレームワーク(☞【2】)。

🐾1 正確に言うと、6段階である。ただし、ステージ0(☞【2】⓪)は非常に重要であるものの、アルゴリズムやアプリケーション開発そのものではないため、5段階には含められていない。

(3) 実用的な量子アプリケーション探索・開発において、「問題優先」アプローチは機能しない。機能するアプローチは、「アルゴリズム」優先アプローチである(☞【3】(3)2⃣及び❚補足3❚を参照)。

(4) 暗号解析並びに量子シミュレーション以外で、実用的な量子アプリケーション探索・開発は、(極めて)困難であることが証明されている🐾2。

🐾2 天下り的に示されされているのみなので、モヤっとするが、結論に違和感はない。なお、「(極めて)困難であることが証明されている」という言葉の意味も曖昧模糊としていて、やはりモヤっとする。原語では、以下の通り:the search for practical quantum applications has proven remarkably difficult.

(5) 量子シミュレーションにおける量子優位性の実現ハードルは、量子物理シミュレーションは低い(早期に達成する可能性がある)が『実用的な』量子アプリケーション探索・開発には直結していない。量子化学シミュレーションは『実用的な』量子アプリケーション探索・開発に直結するが、量子優位性の実現ハードルは高い(☞【6】(4)㈢)。

(6) 「回路の深さと論理量子ビットの数を減らす」といった単純な経験則は、初期誤り耐性アルゴリズムの探索において、しばしば不十分(場合によっては有害)である。

(7) 量子アルゴリズムと量子誤り訂正アーキテクチャの詳細を、共同設計することが極めて重要になる。

【2】5段階フレームワークの概要(頭出し)

⓪ステージ0 ー為参考扱いー

量子情報科学における基礎研究❚補足1❚。

❶ステージⅠ

抽象的な設定における、新しい量子アルゴリズムの発見(☞【4】)。

❷ステージⅡ

量子優位性を示す問題の特定(☞【5】)。

❸ステージⅢ

実社会のアプリケーションにおける量子優位性の確立(☞【6】)。

➍ステージⅣ

ユースケースのための最適化・コンパイル及び量子リソースの推定(☞【7】)。

❺ステージⅤ

量子アプリケーションのデプロイ🐾3(☞【8】)。

🐾3 ITの文脈におけるデプロイとは、「ユーザーが利用可能な状態にする」ことを指す。ここでは、(量子アプリケーションが)実用的なワークフローに、実際に導入される(埋め込まれる)ことを指している。

❚補足1❚

ステージ0のみ、ここで、若干追記する。ステージ0は、量子計算の能力に対する根本的な限界を確立する「量子情報理論と複雑性理論」の基礎研究を網羅する。量子情報理論は、特定の問題に対して量子高速化が不可能であることを証明している。量子複雑性理論は、あらゆる状況で機能する効率的な量子アルゴリズムは、期待できないことを多くの例で示している。

【3】実用的な量子優位性の”実現困難性”に関する論点整理

(1) 検証可能性

検証可能性は、バズワードになっているのかもしれない。[*A-63]及び[*A-65]でも言及されている。本PPは、検証可能性は、量子アルゴリズムの有用性にとって必要条件である(ただし十分条件ではない)と主張する。検証可能性について具体的に、以下のような説明が付されている:2つの異なる量子コンピュータがシミュレーションを実行し、同じ答えを得ることができれば、これは実験的に検証可能な予測と見做すことができる。しかし、ランダム回路サンプリングなどの一部のサンプリングタスクでは、これは当てはまらない。

(2) 古典的に困難なインスタンス及び超2次加速の必要性

㈠ 量子優位性が実現したか?を判別するには、量子アルゴリズムだけでなく、「量子的には容易でありながら、古典的には困難なインスタンスを、サンプリングする方法」も必要である。多くの場合、そのサンプリング方法が欠けている。

㈡ (今後20年以内と定義されている)近い将来 に、計算モデルにおいて実用的な量子優位性を達成するには、おそらく2次加速を超える高速化(超2次加速)が必要である🐾4。多くの問題は振幅増幅などの標準的な手法を用いた2次加速に適しているが、より高次の加速を実現するアルゴリズムを発見することは、かなり困難である。

🐾4 これは、量子界隈で従前から共有されてきた、共通認識と思われる。

(3) アルゴリズム to アプリケーション

1⃣ アプリケーション探索が難しい技術的理由と社会学的理由

古典的に困難なインスタンスに対して、明示的に効率的な量子アルゴリズムであっても、それはまだ量子アプリケーションとは言えない。最大のボトルネックは、抽象的なアルゴリズムを実世界の問題に対するソリューションへと変換し、アプリケーションとすることである。量子シミュレーションと暗号解析以外で、この変換(量子アプリケーションの探索)は、困難であることが証明されている(らしい)。このアプリケーション探索が困難である主な理由は、2つある、と本PPは主張する。

1つ目は技術的なものである。超2次加速を実現するアルゴリズムのほとんどには、データ構造、行列の疎性、条件数❚補足2❚など、商業的に関心の高い問題ではほとんど満たされない厳格な基準が多数存在する。2つ目は社会学的なものである。量子アルゴリズム研究者と実世界ドメインの専門家の間には、根強い知識格差が存在する。新たな用途を見つけるには、この溝を埋めるための稀有な学際的なスキルセットが必要である。

2⃣ マーケット・プルは機能しない。テクノロジー・プッシュを推奨。そして生成AI

本PPは、以下のように論じる:「問題優先」アプローチ、つまり産業上の課題から出発し、エンドユーザーのニーズに対応しながら、量子アプリケーションを探索するアプローチ🐾5は、ほとんど成果を上げない。そして、効果的なアプローチは、「アルゴリズム優先」アプローチである、と断ずる❚補足3❚。

アルゴリズム優先アプローチ🐾6は、次のように進められる。まず、明確な優位性を持つ既知の量子プリミティブ(例えば、量子シミュレーション)から始める。次に、必要な数学的構造にマッピングされる現実世界の問題を探索する。本PPは、生成AIが、異分野間の知識ギャップを埋めるのに役立つ有用なツールになる可能性があると考えている。

🐾5 イノベーション理論で使われる文言で言えば、マーケット・プル(あるいはニーズ・プル)ということになる。マーケティング理論であれば、マーケット・イン。

🐾6 イノベーション理論で使われる文言で言えば、テクノロジー・プッシュということになる。マーケティング理論であれば、プロダクト・アウト。エフェクチュエーション(理論に基づく、新しいアプリケーションの開発)と考えても良いだろう。

❚補足2❚

改めて、この場合の問題セットアップを書き下すと、以下のようになる:連立一次方程式系を、係数行列A×未知である解ベクトルx=既知のベクトルb、という形式に変換して数値的に解く。このとき、係数行列に対して定められる、「当該問題を、数値的に解くことが適切か否か」を判定する指標を条件数と呼ぶ。条件数が小さければ、良条件である。

別の表現を使うと、bの変化量に対するxの変化量の割合を表す量が条件数である。つまり条件数が大きい場合を例えるなら、bに若干のノイズが加わっただけで、解xが大きく変化する(誤差が大きくなる)ケースということになる。

一般的に、真に革新的で大きく化けるアプリケーションは、プロダクト・アウト型と言って良いと思われる。B2Cで言うと、YouTube、旧twitter(現X)、TikTok等は全て、プロダクト・アウト型であろう。ポケモンGoも、プロダクト・アウト型であろう。ただ、先の全てのアプリケーションは出自がプロダクト・アウトであっても、その後PDCAサイクルを高速で回して、顧客ニーズと合致するようにブラッシュ・アップされている。B2BだとMonotaRoが上げられるだろうが、こちらも同様に、PDCAサイクルを高速で回して、顧客ニーズと合致するようにブラッシュ・アップされている。

残念ながら、量子アプリケーションの場合、そういう訳には行かない。実用的な量子優位性が現れるかは、数学的に厳密に規定される。顧客ニーズが、そこになければ、アプリケーションを開発すること自体エコノミクス的に成立しないだろう。実用的な量子優位性を達成する量子アプリケーションの探索・開発は、相当難しいタスク(あるいは無理ゲー?)になると思われる。本PPでは、生成AIが突破してくれることを期待している。

ちなみに、量子コンピューターの将来性を語るとき、「フォン・ノイマンは賢明にも、電子計算機のユースケースを限定しなかった」という逸話が頻繁に引用される。ただ、「問題優先」アプローチではなく「アルゴリズム優先」アプローチでなければ、実用的な量子アプリケーション開発は成功しないというのであれば、フォン・ノイマン逸話のアナロジーが成立しない。由々しき事態である。

㈡ 解決策の具体例

生成AIへの過大な期待は、とりあえず脇に措くことにする。マーケット・プルもプロダクト・アウトも、どちらもダメなら、(一周してやっぱり)マーケット・プルを志向した方が良いと思われる。技術的には、㊀効率的に状態準備する技術=効率的な量子符号化技術、㊁条件数を小さくする技術、等を地道に開発していくことが近道ではないかと思われる。

㊀では米Haiquが有名。Haiquは自社公式ブログで、異常検知において量子有用性を確認したと明らかにした(25年11月13日付け)。鍵となったのは、新しい符号化手法の開発である(こちらを参照)。また、加ザナドゥ(光量子H/Wスタートアップ)・英リバーレーン(S/Wスタートアップ)・英ロールスロイスは、航空機エンジン周りのジェット気流に対するシミュレーションを量子コンピューターで効率的に行えることを実証したと発表(25年11月15日)🐾7。詳細は明示されていないが、効率的な量子符号化技術が鍵であると推測される。

㊁に関しては、慶応義塾大学が、代謝ネットワークを解析する量子アルゴリズムを対象に、提案している(@bioRxiv、25年10月27日)🐾8。具体的に言うと、係数行列Aのヌル空間射影に正則化を加えることで、条件数を削減する方法を提案している。

🐾7 https://www.xanadu.ai/press/xanadu-rolls-royce-and-riverlane-unlock-dramatic-improvements-for-applications-to-jet-engine-airflow-simulations-using-quantum-computing

🐾8 こちらを参照。

㈢ 蛇足・壱

ハーバード・ビジネス・レビューの記事「Quantum Thinking Can Help You Solve Complex Strategy Challenges」[*A-95](25年11月21日)は、「今日の最も困難な経営戦略課題の多くは『変数が複雑な相関関係を有する・最終結果が変化する・ステークホルダー間の関係が複雑である』ことによって、これまでの分析では捉えきれない問題である」と説いている。そして、それらの『ヤバイ🐾33』問題は、「量子インスパイアード・アルゴリズム×古典コンピューター若しくは、量子アニーラ」を使って、解けると宣う🐾34。

当該記事の意図は、「現時点でも、量子(周りの)技術は経営に正のインパクトを与えているのだから、将来の量子技術に対しても、安心して関わって行きまっしょい」というものであろう。

🐾33 原語ではwicked。本来の意味は、ひどく悪い、厳しい、といった意味。俗語では、素晴らしい、優れた、すごい、という意味を持つらしい。

🐾34 具体的には、量子アニーリング→物流最適化、量子ベイジアンネットワーク→治験の優先順位付け(薬物動態解析)、射影量子カーネル法→金融不正行為の検知。

㈣ 蛇足・弐

真に革新的で大きく化けるアプリケーションが少数であることは、ほぼ自明であろう。これは、(超多項式の)量子加速を実現するケースは限定されるであろうという予想(アーロンソン・アンバイニス)と、悲しくも整合する。つまり、実用的で量子優位性を達成するアプリケーションは少数、と考えることが合理的である。バンドワゴン効果が働くネットワーク・ビジネス、あるいは収穫逓増が働くソフトウェア・ビジネスで、勝者総取りは当たり前になったから、それほど驚くことでもないが、量子アプリケーションでもwinner takes allは蓋然性が高い。ただ、量子アプリケーション開発は、開発コストが相当高いと見込まれる。先端半導体、大規模データセンターあるいは核融合発電関連装置等々、投資額が膨らむ対象も増えてきたから、こちらもサプライズはないかもしれないが、とは言え、野放図に投資するわけにもいかないだろう。ここで、国家レベルにおいて経営戦略的・事業戦略的思考を発動させると、「そんなリスキーなトピックに、日本企業は手を出すべきか?」という議論も当然、起こるだろう。正面から量子アプリケーションを取りに行くというのではなく、戦略的な動きが必要かもしれない。

(4) ダメ押し:成功要件

㈠ 本PPは追い打ちを掛けるが如く、初期誤り耐性時代において量子アプリケーション開発を商業的に成功させるには、以下が不可欠と主張する:量子誤り訂正(QEC)アーキテクチャの慎重な検討、場合によっては、QECアーキテクチャと量子アプリケーションとの共同設計。これは、NISQ時代において、対象となるハードウェア・プラットフォームの詳細を慎重に検討する必要があったことと同じである。さらに、以下を注意喚起する:「回路の深さと論理量子ビットの数を減らすことに重点を置く」といった単純な経験則は、(量子アプリケーション開発の前段である)初期誤り耐性量子アルゴリズムの探索を導く上で、しばしば不十分(場合によっては有害)である。

㈡ また本PPは、量子アプリケーション開発において、不幸なビジネス上(あるいは競争戦略上)のインセンティブ構造が存在することを指摘する:新しいアプリケーシの必要性は広く認識されているが、主要な量子研究における競争優位性は主にハードウェアにあると見做されている。この見解は、アルゴリズムの知的財産権は重要でない、あるいは比較的容易に回避できるという考えと結び付けられることが多い。結果として生じるインセンティブ構造は、以下のようになることが懸念される:個々の企業にとって支配的な競争戦略は、防御可能なハードウェアに過大なリソースを集中させることである。アプリケーション開発は、他のグループや学者に任せる。

㈢ 小括的にまとめると、ビジネス的に成功する量子アプリケーションの開発は、科学や技術以外にも複数要因が絡み合って、相当困難であると思われる。(3)1⃣社会学的理由及び2⃣は、経営学的というかイノベーション理論的に、困難さを詳らかにしていると思われる。そして、(4)㈠は技術的に高度な要求であり、(4)㈡は「ビジネスとして成功する量子アプリケーション」を考えた場合の、絶妙な陥穽であるように思われる。ただ、(3)㈣も考え合わせるべきであろう。

(5) 為参考:期待値計算における量子優位性

㈠ 量子優位性が最初に主張された(そして直ちに否定された)のは、2019年byグーグルであった。これは、最高の古典アルゴリズムに対して、サンプリングにおいて量子優位性を獲得したという主張であった。期待値計算における量子優位性の最初の主張は、2024年になってようやくなされた。2024年には米IBM🐾9と加D-Wave🐾10によって主張されたが、その後まもなく、比較的標準的な手法を用いて複数のグループから反論を受けた。2025年になり、米クオンティニュアム🐾11とグーグル🐾12によって主張がなされ、クオンティニュアムの結果は、古典的にシミュレーションされた🐾13。

🐾9 横磁場イジングモデルの量子シミュレーション。なお、この結果は2023年である(ので誤植)。6月14日にnatureにてオンライン公開された(オープンアクセス)。9月27日に古典アルゴリズムが、2秒@ラップトップで実行された。古典アルゴリズムは、テンソルネットワーク(グラフベースの射影エンタングル対状態(グラフベースのPEPS))を使った。こちらを参照。

🐾10 同じく、横磁場イジングモデルの量子シミュレーション。arXivでは24年3月、査読済版(Science)では、25年3月に公開。こちらは、部分的に反論されている。こちらを参照。

🐾11 同じく、横磁場イジングモデルの量子シミュレーション。古典手法を用いた正確なシミュレーションが(可能だとしても)極めて困難な時間スケールにおいて、「2段階緩和過程(フロケ prethermalization)」の出現を観察した、という内容。2段階緩和過程とは、準定常状態

に一旦緩和した(第1段)後に、真の定常状態に緩和する(第2段)という熱平衡化過程を指す。

🐾12 非時間順序相関関数(OTOC)のシミュレーションである。こちらを参照。

🐾13 ただし25年11月時点で、公開されていない。本PPのリファレンス([96])でも準備中(in preparation)となっている。

㈡ Quantum Advantage Tracker

量子優位性が実現したのか?を、学術界及び技術コミュニティが公開検証するサイトが、25年11月12日に立ち上がった。それが Quantum Advantage Trackerである(https://quantum-advantage-tracker.github.io/)。設立メンバー?として、米IBM、フィンランドAlgorithmiq(S/Wスタートアップ)、米BlueQubit(S/Wスタートアップ)、理化学研究所が名を連ねている。

量子優位性を検証する問題のカテゴリーとして、オブザーバブル期待値の推定問題、変分量子アルゴリズムに関する問題、量子優位性を古典的に検証可能な問題、が上げられている。

【4】ステージⅠ|抽象的な設定における、新しい量子アルゴリズムの発見

(0) 定義及び射程

ステージIの研究は多くの場合、最悪ケースにおける漸近的複雑性、つまり最も困難なインスタンスに対するアルゴリズムのスケーリングに焦点を合わせる。クエリ・モデルなどの単純化された計算モデルにおける問題を解くためにブラックボックス・オラクルを呼び出すアルゴリズム(サイモンのアルゴリズム🐾14)は、ステージIの対象範囲となる。

ステージIには、量子アルゴリズム分野における多くの基礎的成果が含まれる。代表的な例としては、グローバーのアルゴリズム、、量子位相推定、アーベル群の隠れ部分群問題🐾15の量子アルゴリズムなどが挙げられる。また、量子断熱アルゴリズム、近似的量子最適化アルゴリズム(QAOA)、線形方程式のシステムの解法(HHLアルゴリズム)、ジョーンズ多項式の計算🐾16などの BQP問題のアルゴリズムも含まれる。

🐾14 サイモンのアルゴリズムは、最良の確率的古典アルゴリズムに対して、「指数関数的な優位性」をもたらすことが証明されている。残念ながら、その直接的な実用的応用は知られていない。ただし、ショアのアルゴリズムは、サイモンのアルゴリズム(の周期探索)に着想を得て開発された、とされる。なお、ショアのアルゴリズムが全ての古典アルゴリズムに対して「指数関数的な優位性」をもたらすことは、未証明である。

🐾15 アーベル群(可換群)の可換性を利用して、群にある隠された構造を探索するという問題らしい。サイモンのアルゴリズム(そしてショアのアルゴリズム)は、同隠れ部分群問題の量子アルゴリズムに属する。

🐾16 BQP問題の代表例として、しばしば上げられる。BQP問題とは、古典コンピューターでは最悪の場合(入力サイズに関して)指数時間を要するが、量子コンピューターなら効率的に(=入力サイズに関する多項式時間で)解ける問題である。ジョーンズ多項式は、結び目不変量の中でも代表的な多項式不変量。

(1) ステージIにおける超2次的高速化に関する成果の一部🐾17

🐾17 一部の意味は、本PPが網羅性を保証していないことを、自ら表明しているという意味である。従って、本稿が本PPの一部を抜粋したと言う意味ではない。

1⃣ カテゴリー:BQP問題

㊀ 結び目不変量の計算(ジョーンズ多項式の計算)

詳細は割愛。🐾16参照。

㊁ 線形方程式系の解法(HHLアルゴリズム)

メジャーなので割愛。

㊂ 連成古典振動子ダイナミクス

バネで結合された2n個の質量(結合振動子)を記述する古典力学をシミュレートする量子アルゴリズムが、古典アルゴリズムより指数関数的に速いことを示した[*A-78]。ただし、個々の質量とばね定数を効率的にクエリ可能、初期状態は効率的に準備可能、という前提条件が付く。

㊃ 量子多体系の局所最小値の探索

量子多体系の基底状態を見つけることは、量子コンピューターにとっても難しい。つまり、基底状態を常に効率的に見つけることができるとは限らない。その代わり、量子コンピューターなら(大域的でない局所的な)極小値は、基底状態よりも遥かに簡単に見つけることができる。BPP ≠ BQP という未解決の計算複雑性理論における仮定を認めると、そのような極小値であっても、古典コンピューターで見つけることは困難であることが証明できる。

結論的に言うと、熱摂動下で量子多体系の局所最小値を探索する問題は、特定のハミルトニアンに限定すれば、超多項式の量子優位性が得られる[*A-79]。

㊄ 汎用ハミルトニアン・シミュレーション

割愛。

2⃣ カテゴリー:オラクル問題

㊀ サイモンのアルゴリズム

詳細は割愛。🐾14参照。

㊁ Forrelationの推定

Forrelationとは、2つのブール関数f及びgが与えられた時、gとfをフーリエ変換した関数との相関関数を指す(らしい)。つまり、Forrelation=相関関数(ℱ(f),g)である。ここで、ℱ(f)は関数fのフーリエ変換を示している。先の式は、紛らわしいが、forr=(f,g)と表記される。この Forrelationを推定する問題において、量子アルゴリズムは古典アルゴリズムよりも、指数関数的な高速化をもたらすようである[*A-80]。

ただし、±1ではなく±2/π の範囲でしか、指数関数的な高速化の射程範囲ではない。つまり、forr(f, g) ≥ 2/π と forr(f, g) ≤ −2/π を区別する場合に、指数関数的な高速化が実現する[*A-81]。

㊂ 山川-Zhandry問題

量子コンピューターによって指数関数的に高速に解けることを、世界で初めて証明した「構造なしのNP探索問題」[*A-82]。構造なし、とは、量子加速に有利となるような何らかの構造(例えば、対称性とか周期性)が、当該問題に一切含まれていないことを意味する🐾18。また、ここで言うNP探索問題とは、古典コンピューターで効率的に(=多項式時間で)検証可能な探索問題、と言う意味である。残念ながら、具体的な応用先は、未だ見つかっていない。

なお、量子アルゴリズムによって指数加速を達成するには、問題に何らかの構造が必要である、と主張する「Aaronson-Ambainis予想」と呼ばれる有名な予想がある。この予想と、 山川🐾19-Zhandry問題の存在は矛盾しない。同予想の対象が決定問題であるのに対し、山川-Zhandry問題の対象は探索問題であるため。

🐾18 指数加速を実現した重要な量子アルゴリズム・プリミティブは、QFT(量子フーリエ変換)であるが、指数加速に周期構造を活用しているわけではない。

🐾19 世界的に著名なNTTの研究員、山川高志氏。

㊃ 接合木(Glued trees)問題

古典コンピューターよりも指数関数的に高速に解くことができるオラクル問題である[*A-83]。グラフの構造及び初期状態に、特定の条件が必要。量子アルゴリズム・プリミティブは、量子ウォークである。量子ウォークを使用して、グラフを高速に走査することで、「初期状態(特定の入口)から終状態(特定の出口)に到達するまでに要する、最小ステップ(最小時間)を求める」という探索問題🐾20である。

なお、特定の入口から特定の出口までの、特定の経路を見つけるという問題には適用できない。

🐾20 決定問題に変換することも可能。

㊄ アーベル群の隠れ部分群

詳細は割愛。🐾15参照。

3⃣ カテゴリー:その他

㊀ 量子断熱アルゴリズム

詳細は割愛。

㊁ QAOA

詳細は割愛。要補足

㊂ トポロジカル・データ解析

大規模なデータセットから有用な情報を抽出するタスクを設定する。大規模なデータセットを扱うため、トポロジカルな手法(パーシステント・ホモロジー)を適用する。単体的複体を構築し、ベッチ数を計算する。ベッチ数を使って、組み合わせラプラシアンの固有ベクトルと固有値を見つける。単体的複体の構築及びベッチ数の計算において、古典アルゴリズムに対して量子アルゴリズムは、指数関数的に高速である[*A-84]。量子アルゴリズム・プリミティブは、量子位相推定法である。ただし、qRAM(量子メモリー)の存在が仮定されている。

㊃ 微分方程式のシミュレーション

割愛。

㊄ 浅い量子回路の生成学習

割愛。

(2) 提言

グーグルは自社の経験から、次を示唆する:新しい量子アルゴリズムが全くの無から生まれることは稀であり、先行研究(多くの場合「ステージ0」)から、何らかのインスピレーションを得ている。つまり、より基礎的でリスクの高い研究を推し進めるべきと主張する。一方で、「量子アルゴリズム研究者のうち、アルゴリズムの基礎的かつ高リスクな研究に注力している割合が比較的少ないように見えるのは、学界と産業界における構造的なインセンティブが、リスク回避的な行動を意図せず助長していることが一因かもしれない」という懸念を表明している。

その上で、「より多くの研究者が、新しい量子アルゴリズムの大胆かつ基礎的な探索に取り組むよう促す方法を見つけることには、大きな潜在的なメリットがある。評価と資金提供のメカニズムは、漸進的な改善だけでなく、独創性、問題発見、そして困難なアイデア(十分に裏付けられた否定的な結果も含む)の慎重な探求を評価するべきである」と提言している。

【5】ステージⅡ|量子優位性を示す問題の特定

(0) 定義及び射程

㈠ ステージIの結果は、量子コンピュータが既知の古典アルゴリズムよりも優れた性能を示すことが期待される「(たとえ人為的なものであっても)具体的な問題インスタンス」を、効率的に生成できるようになった時点で、ステージIIへと進む。例えば、ある問題が効率的に構築可能なアンサンブル全体にわたって平均的に超2次的な高速化を示すことが示された場合、ステージIIは達成される。

従って、最悪のケースにおける高速化のみを示す結果は、まだステージIIではない。なぜなら、量子高速化が既に知られている他の問題を埋め込む以外に、古典的に困難なインスタンスを生成する方法がわからない可能性があるからである(☞【3】(2))。

㈡ ステージIIの結果は『抽象的な問題、あるいは人為的な問題を対象としても構わない』。その理由は、以下の通り:量子優位性が理想的な厳選された設定で実証できない場合、複雑な現実世界の応用(ステージIII)で量子優位性を発見できる見込みは、おそらくほとんどない。

㈢ ステージIIの結果は、2つの関連する課題に対処する必要がある、と本PPは主張する。1つ目は、量子アルゴリズムの出力が入力に依存しない平均値に集中せず、入力に依存する信号を明らかにするような問題インスタンスを特定すること。2つ目の課題は、量子アルゴリズムと競合する可能性のある膨大な数の(おそらくヒューリスティックな)古典アルゴリズムを考慮する必要があること。

さらに本PPは、次のように宣誓している:ステージ II は応用に向けた必要なステップであるだけでなく、ステージ I と同様に量子優位性の追求の核心であると信じている。

(1) ステージIIにおける超2次的高速化に関する成果の一部🐾17(再)

1⃣ カテゴリー:周期構造の探索

㊀ ショアのアルゴリズム|指数加速|古典的に検証可能

割愛。

㊁ 主イデアル問題とペル方程式の求解[*A-85]|指数加速|古典的に検証可能

[*A-85]🐾21は、計算代数的数論(計算数論)における3つの問題に対して量子アルゴリズムを開発した論文である。開発された量子アルゴリズムのプリミティブは、アーベル群の隠れ部分群である。一つ目は、ペル方程式の整数解を求める問題。二つ目は、実二次体上の主イデアル❚補足4❚問題。3つ目は割愛する。

整数の素因数分解は、ペル方程式の整数解を求めることに帰着する。そして、ペル方程式の求解は、主イデアル問題に帰着する。実用性という意味では、暗号解析の分野で、暗号プリミティブとして使用することが考えられる。なお、ペル方程式とは、以下のように表される方程式である。

x2 − d・y2 = 1

ここで、dは、平方数ではない自然数である。x,yは整数である。

🐾21 論文の著者(単著Sean Hallgren)は、当時(2006年)、NEC北米研究所に在籍していた。それ以前は、米カリフォルニア工科大学在職で、それ以後は米ペンシルベニア州立大学在職。NEC北米研究所には、AIゴッドファーザーの一人、ヤン・ルカンも一時在籍していた。

㊂ 代数曲線のゼータ関数[*A-86]|指数加速|量子的に検証可能

[*A-86]🐾22は、有限体🐾23上の、種数🐾24gを持つ曲線のゼータ関数❚補足5❚を決定する量子アルゴリズムを開発した論文である。プリミティブは、アーベル群の隠れ部分群だと思われる。実用性という意味では、暗号解析の分野で、暗号プリミティブとして使用することが考えられる。

🐾22 [*A-86]はAcknowledgmentsにおいて、Sean Hallgrenに謝辞を述べている。この分野(計算数論)において、Sean Hallgrenは第一人者ということであろう。ちなみに[*A-86]も単著であるが、数学分野では単著が多いことが知られている。

🐾23 有限個の要素からなる体(field)。体=四則演算が可能になるような代数構造が導入された集合。

🐾24 所謂「穴の数」である。英語ではgenusなので通常、gの文字が当てられる。

㊃ 単元群及び類群[*A-87]|超多項式加速|古典的に検証可能

[*A-87]は、体上の🐾25と類群🐾26の計算は、計算数論における主要な問題であるとして、それらの問題を多項式時間で計算する量子アルゴリズムを開発した論文である。プリミティブは、アーベル群の隠れ部分群である。[*A-87]の著者(単著)は、[*A-85]の著者Sean Hallgrenである。㊁で示した通り、整数の素因数分解は、ペル方程式の求解に帰着する。ペル方程式の求解は、単元群の計算の特殊なケースである。そして、古典的には、単元群の計算と類群の計算は密接に関連している。

🐾25 英語ではunit group。環の中で、乗法に関して可逆な元全体の集合は、乗法に関して群を成す。この群を単元群と呼ぶ。

🐾26 英語ではclass group。主イデアルの集合を法とする、イデアルの集合として定義される、有限アーベル群。類群は1798年にガウスによって発見された。類群には2つの応用が広く知られている。1つは素因数分解アルゴリズムであり、素因数分解は類群の計算に帰着する。もう1つはフェルマーの最終定理の潜在的証明である。

㊄ 2変数指数関数合同関係[*A-88]|3次加速|古典的に検証可能

[*A-88]は、有限体Fq上の afx + bgy = cという形式の方程式に対する、可解性判定と整数解 {x,y}を求めるための古典及び量子アルゴリズムについて議論した論文である。計算量q9/8 (log q)O(1)の古典アルゴリズムに対して、q3/8 (log q)O(1) の量子アルゴリズムを提示している。つまり、3次加速を実現している。qは、ある素数pと適当な自然数nから、q=pnと計算される。有限体の元の個数が、qである。

❚補足4❚

イデアルの名は、エルンスト・クンマーが導入した理想数(ideal number)に由来する。代数的整数においても(有理整数と同様に)、素因数分解の一意性成立させるために導入された。その後、リヒャルト・デデキントによって厳密に定義された。イデアルをザックリ定義すると、環Rが与えられた時、「良い性質を持つよう」に作られた部分環Iということになる。良い性質をどのように付与するか?という自由度があるので必然的に、イデアルは、多種多様になる。主イデアル(principal ideal)を無味乾燥的に定義すると、R の単元により生成されたイデアルである。

❚補足5❚

ゼータ関数は、何十種類もある。最も有名なゼータ関数は、リーマンのゼータ関数である。ここでいう、曲線Cのゼータ関数Zは、次のように定義される。

Z(C,t)=P(t)/[(1-t)(1-qt)]

P(t)は、P(0) = 1を満たす次数2gの適当な多項式(gは種数)。qはある素数pに対してq = pnと定義される。nは、適当な自然数である。

2⃣ カテゴリー:位相推定

㊀ ガウス和|超多項式加速|量子的に検証可能

割愛。

㊁ テンソル主成分分析|4次加速|古典的に検証可能

割愛。

㊂ ノイズがある場合の疎行列の固有値を求める問題[*A-89]|4次加速|古典的に検証可能

[*A-89]は、ノイズの多いデータに隠れた構造を見つける「プランテッド(planted)推論問題」と呼ばれる問題群において、最良の古典手法と比較して4次加速を実現する量子アルゴリズムを提示した論文である。加えて、この量子アルゴリズムは、最良の古典手法と比較して、必要なメモリ量が指数的に少ない。

プランテッド(planted)推論問題は、疎行列の最大固有値を求める問題として再定式化される。量子コンピュータ上では、この疎行列は平均場ハミルトニアンとして扱われる。キクチ法❚補足6❚によって、所望の解に近い状態を準備することにより、まず、2次加速を実現する。次に、量子位相推定と量子振幅増幅法を使って、さらに2次加速を実現する。都合併せて、4次加速を実現している。量子アルゴリズム・プリミティブは、キクチ法・量子位相推定法・量子振幅増幅法、ということになる。

実用的な応用先という意味では、暗号解析、ネットワーク内のコミュニティ検出(☞下記㊃)あるいは複雑なシステムにおける信号の同期など、に適用できると考えられている。

㊃ コミュニティ検出[*A-90]|4次加速|古典的に検証可能

ネットワーク分析において、コミュニティ検出は重要なタスクの1つとされる。具体的に述べると、ネットワーク内で密接に結合したノードのグループを見つけ出すことを、コミュニティ検出と呼ぶ。[*A-90]は、ハイパーグラフ・コミュニティ検出のための量子アルゴリズムを開発した論文である(arXivでの公開が、25年10月9日と新しい)。量子アルゴリズム・プリミティブは、キクチ法(の量子化バージョン)である。

最良の古典アルゴリズムに対して、4次加速と超多項式のメモリ節約を実現する。なお、[*A-90]の筆頭著者と[*A-89]の筆頭著者は同じ。

❚補足6❚

キクチ法は、次数pの最適化問題を次数2の最適化問題に縮約する一般的な手法である。次数2の問最適化題は行列でモデル化できる=線形代数的手法を用いることができるため、計算機で取り扱い上で望ましい。キクチ法を最初に導入した[*A-91](ver1は2019年、最新ver3は2025年8月19日)によると、キクチ法とは、ベーテ・ヘッセ行列を一般化したキクチ・ヘッセ行列に基づくスペクトル法である。

3⃣ カテゴリー:隠れシフト問題

㊀ ルジャンドル記号問題[*A-92]|指数加速|古典的に検証可能

[*A-92]🐾27は、次のように問題提起する:これまでに発見された最も成功した量子アルゴリズムのほぼすべては、量子フーリエ変換(QFT)の能力を利用して関数の部分群構造、特に周期性を復元している。一方、QFTが『隠れシフト問題』にも使用できるという事実は、量子計算の文脈ではほとんど注目されていない。隠れシフト問題とは、2つの関数fとg及び任意のxに対して、f(x) = g(x + s)となるシフトsを求める問題である。

というわけで、[*A-92]はQFTを用いて量子コンピュータ上で効率的に解くことができる、未知のシフト問題の例を3つ示している🐾28。未知のシフト問題の一つが、シフトされたルジャンドル記号問題である。これは、関数f(x)=((x+s)/p)をオラクルとして与え、sを求める問題である。ここで、(a/p)はルジャンドル記号で、p がaを割り切る場合は 0、aがp を法とする平方剰余の場合は 1、aがpを法とする平方剰余でない場合は-1 と定義される。

🐾27 著者の一人は、Sean Hallgren。

🐾28 実用性と言う意味では(おそらく)、だから何?という論文であろう。学術的には、隠れシフト問題と隠れ部分群問題を一般化して、隠れ剰余類問題を定義しており、十分な意味があるのだろう。

㊁ 楕円曲線同種写像[*A-93]|超多項式加速|古典的に検証可能

[*A-93]は、同種写像ベースの暗号システムが、格子ベースの量子耐性暗号システムと競合できない可能性があることを示唆した論文である。

4⃣ カテゴリー:Regevによる削減❚補足7❚

㊀ 最適多項式交差問題|指数加速🐾29|古典的に検証可能

最適多項式交差問題(OPI)とは、有限体上の多項式回帰問題である。OPIに対して、グーグルは「復号量子干渉法(DQI)」という量子アルゴリズムを提案している。DQIにおいてOPIは、復号の双対最適化問題と見做される。DQIはQFTによって、古典的に困難と思われる問題を古典的に容易に解ける復号問題にマッピングすることで、超多項式加速を実現する。量子アルゴリズム・プリミティブは、QFTということになる。

なお、非構造化組合せ最適化問題においては、DQIは量子優位性をもたらさないことが示されている。

🐾29 本PPママ。

㊁ 山川-Zhandry問題|指数加速|古典的に検証可能

既出☞【4】(1)2⃣㊂を参照。

❚補足7❚

本PPでは、量子計算と格子問題との間に、明確な関連性を初めて示した論文[*A-94]が上げられている。格子暗号に対して僅かに、量子加速が生じることを示している。一般的に、Regev(Oded Regev)による削減というと、ショアのアルゴリズムを改善する方法が初めて提案された事案を想起する。こちらを参照。

5⃣ カテゴリー:QAOA

㊀ 8-SAT問題に対するQAOA|超4次加速|古典的に検証可能

割愛。SAT=充足可能性問題。

6⃣ カテゴリー:物理シミュレーション

㊀ OTOC|指数加速|量子的に検証可能

こちらを参照。

(2) ステージIIの核心的な難しさ・其の壱|矛盾

ステージIIにおける大きな課題は、次のような二律背反である:量子アルゴリズムは、古典コンピュータによるシミュレーションを困難にするために、大きなエンタングルメントを持つ非常に複雑な状態を生成する必要がある。他方では、これらの複雑な状態は、しばしばスクランブル(量子情報の非局在化)または熱化を示し、オブザーバブルが統計的に予測可能になる。スクランブルされた量子状態では『オブザーバブルは平均値の周辺に密集する傾向があり』、特定の問題入力に関連付けられた固有の「信号」が消去される。そのため、単純な古典アルゴリズムは、この予測可能な平均値を出力するだけで競合することができる。これは、ランダムにサンプリングされた量子状態や、ランダム量子回路の出力によって生成される状態に典型的に見られる挙動であると考えられる。

同様に、一般的な強相関系のハミルトニアンは、しばしば普遍的な挙動へと熱平衡化し、その集団特性はランダム行列理論や、単一の非ランダム量子状態によって予測可能である。ステージIIにおける主要な課題は、この普遍的な挙動に対する補正が観測可能(つまり、指数関数的に小さくない)であり、かつ古典的なアルゴリズムでは予測できない問題クラスを見つけることである。

(3) ステージIIの核心的な難しさ・其の弐|動く標的

ステージIIにおけるもう一つの大きな課題は、競争相手が、㊀ではなく㊁という事実である。

㊀ ステージIでしばしば比較対象となる証明可能な最悪ケースのアルゴリズム。

㊁ 実用的な最先端のヒューリスティックという、常に進化し続ける「動く標的」❚補足9❚。

量子アルゴリズムの平均的なケースの性能を評価するために、理論的な証明や限定的なシミュレーションに頼るのが一般的だが、古典アプローチは、実際に観測された最高の性能によってベンチマークされる。歴史が示すように、最も影響力のある多くの古典アルゴリズムの性能は、解析的に評価することが困難であり、開発には大規模な実証的検証が必要だった。この前例は、特定の量子ヒューリスティックの真の可能性も、大規模量子ハードウェア上で探求できるようになるまでは、依然として秘められている可能性があることを示唆している。

さらに、期待値が出力状態にどの程度集中するかといったステージIIの中心的な問題は、大型量子コンピュータを用いることで容易に研究できるだろう。したがって、古典アルゴリズムにおける”動く標的”が現在ステージIIを困難にしている一方で、将来のハードウェアによって量子優位性への有望な道筋の特定が容易になる可能性がある。

❚補足9❚

広島大学と富士通は、大規模な量子化学計算において計算量を大幅に削減する手法を開発した、と発表(プレスリリースは25年12月3日、論文[*A-98]発表@Applied Sciencesは、25年4月25日)。DMET🐾33を用いた、372原子のCCSD計算🐾34が1.4時間で完了し、従来のCCSD計算🐾35比で1,295倍🐾36の高速化を達成したとする。DMET(⋍DMFT)を使うのだから、対象は強相関電子系という理解で良いだろう。強相関系は量子コンピューティングが最も期待されるターゲットの一つである。103オーダーの加速は、量子への挑戦状として資格ありだろう。ただし、1,295倍のくだりは、[*A-96]にはない。

🐾33 Density Matrix Embedding Theory:密度行列埋め込み理論。教科書的には、大きな分子を複数の小さなフラグメントに分割する量子化学計算手法、と説明されている。動的平均場理論(DMFT)の代替策として、2016年に米Rigetti Quantum Computing(量子H/Wスタートアップ、モダリティ:超伝導)の研究者により提案された。不純物電子の(局所)グリーン関数を見つける問題を、埋め込み問題の1電子縮約密度行列(1-RDM)を決定する問題に置き換える。

🐾34 摂動法を用いたポスト・ハートリーフォック法の例として、結合クラスター(CC)法がある。CC法は、摂動を1電子励起+2電子励起で打ち切った場合、CCSD法と呼ばれる。

🐾35 元ネタは、https://arxiv.org/pdf/2404.12842らしいが、対象となるCCSD計算がよくわからない。

🐾36 1,813/1.4=1,295。

(4) ステージIIの価値

㈠ たとえすぐに実世界への応用がなくても、ステージIIの結果は、ハードウェアの進歩を検証し、アルゴリズムのマイルストーンを実証するために不可欠な、ハードテストケースを生成するための具体的な方法を提供するため、価値がある。目標は、目先の実用性を脇に置き、代わりに「最小限のリソースで、量子優位性を示す最も単純な問題は何か?」という問いに答えることである。

㈡ ステージIIは、単に有用な応用のための前提条件であるだけでなく、量子物理学の複雑さを理解するための根底にある根本的な問いを表している。

㈢ 本PPは、「多くの物理学者は、量子シミュレーションにおいてステージIIの結果を見つけることは自明であると考えているため、それに関する論文があまりない、あるいは、問題が非常に難しいため、それに関する論文があまりないと考えているようだ」と述べ、「ステージIIの結果が実証されていないことを強調することで、より多くの研究者がこの重大なギャップを埋めることを期待している」とする。

【6】ステージIII|実社会のアプリケーションにおける量子優位性の確立

(0) 定義及び射程

㈠ 『量子シミュレーションと、暗号技術』以外で、量子加速を維持しつつ革新的なアルゴリズムを、価値が高い実用的問題に直接結び付けることが、ステージIII における目標である。ステージIII は、多くの量子アルゴリズムの「細則」が実世界の問題への直接的なマッピングを妨げているため、非常に困難である。

㈡ (改めて・・・)ステージIIIに到達するのは、実世界の制約とオーバーヘッドをすべて考慮に入れた上で、量子アルゴリズムが有意な高速化をもたらすことが期待される実用的な問題を特定した場合である。

㈢ ステージIIIにおける最も有名な成功例は、ショアのアルゴリズムであり、これは広く使用されている暗号システムの解読に直接応用された。

(1) ステージIIIにおける超2次的高速化に関する成果

本PPに記載なし。該当するアルゴリズムは、ショアのアルゴリズムのみということであろう。

(2) ステージIIIの中核となる課題及び懸念

㈠ 暗号解析と量子シミュレーション以外では、実用的な量子アプリケーションの探索は極めて困難であることが証明されている(らしい)。このギャップこそが、ステージIIIの研究の中核となる課題である。尚、ステージIIIの達成が困難な理由は【3】(3)1⃣及び2⃣にて、簡潔に整理している。

㈡ 本PPが憂う大きな懸念は、ステージIIIへの学術的関心が、それ以前の段階と比較して相対的に低いことである。研究コミュニティでは、ステージIとIIの研究は、ステージIIIよりも「基礎的」であり、より重要であると認識されることがある(ただし、グーグルは同意していない)。既存の量子アルゴリズムの新たな実世界ユースケースを特定した論文は、新しいアルゴリズムの発見ほど高く評価されない可能性が高いだろう。この”文化的バイアス”が、重大な不均衡を生み出している。この分野では抽象的なアルゴリズムのポートフォリオは増えているが、実証された実用的なユースケースは極めて不足しており、このギャップが分野全体の健全性を阻害している🐾30。

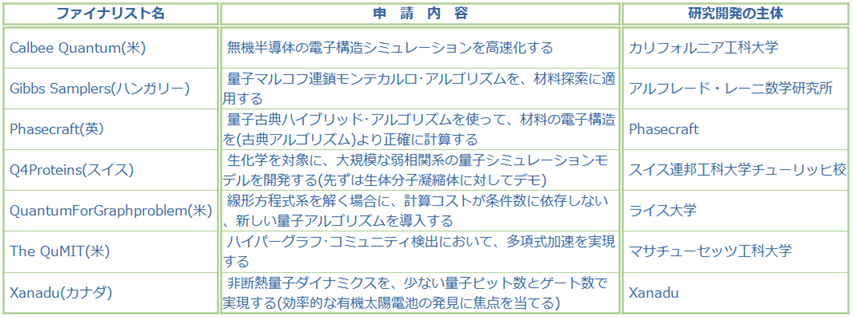

🐾30 より多くの研究者にステージIIIの課題に取り組むよう促すことが、グーグル量子AI XPRIZE 量子アプリケーション・コンペティションを提案し、スポンサーとなった主な動機だったらしい。

7つのファイナリスト・チーム選出を発表(25年12月9日)[*A-107]➡【9】(1)

(3) 量子シミュレーションですら、ステージIII達成が難しい理由

㈠ 暗号解析を除けば、量子シミュレーションはステージIII研究において最も成熟した領域であり、問題とコンピュータ間の自然なマッピングの恩恵を受けている。しかし、この可能性を現実世界への影響へと転換するには、依然として大きなハードルが存在する。本PPでは、以下3つのハードルが具体的に明示されている。

第1に、多くの強力な古典アルゴリズムは、有意な相関長を持ちながら強い相関を示さない、多数のシステムを、既に効果的にモデル化している。第2に、特定の量子計算を実行することで、対象システムの物理に関する重要な未解決の問題を解決できると断言することは困難な場合がある。最後に、シミュレーションを成功させるには、より大規模な技術プロセスにおける適切なボトルネックをターゲットにする必要がある。例えば、創薬における主要なボトルネックは、候補分子を生成することではなく、人体の複雑な環境におけるその有効性と毒性を評価することである。これは現在、費用がかかり、参加者の離脱率が高い臨床試験によってのみ解決可能な課題である。

なお、基底状態において真の漸近的かつ指数的量子加速が存在するかどうかは、未解決の問題である。

㈡ 産業に関連する「天然」分子に関しては、テンソルネットワーク(のような高度な古典的手法)を用いれば、多項式時間で解ける🐾31可能性あり、と主張する者もいる。その一方で、強相関分子の基底状態は、真の漸近極限においては量子コンピュータ上でも効率的に準備できない可能性もある。

🐾31 一部の古典的手法は、理論上は、好ましい多項式スケーリングを持つかもしれない。しかし実際のところ、高精度の化学に対しては、全く実用的でない可能性がある。本PPは、以下を例示している:射影エンタングルド・ペア状態(PEPS)法は、その法外な高スケーリングのために分子の電子構造にうまく適用されたことはない。化学においては、空間次元が高いためスケーリングは、さらに悪化する可能性がある。

㈡ 量子化学シミュレーションが対象とするFeMoco🐾32やP450のような魅力的な分子のユースケースは、産業関連化学全体の中では比較的稀である。量子物理シミュレーションの対象は、遥かに豊富であり、古典的に解決困難な問題を見つけやすい。

🐾32 FeMocoについては、化学的洞察に必要な精度で、その電子構造を解く古典的な手法は存在しないことが分かっている(らしい)。また、真の基底状態と非常に高い重なりを持つ量子状態を、効率的に準備できることも分かっている(らしい)。

㈢ 改めてまとめると、以下のようになるだろう:量子化学シミュレーションの対象は、実用性が厳しく要求されるが故に、モノが少ない。量子優位性×量子化学シミュレーションという文脈で、FeMocoやP450といった少数の同じモノが、頻繁に現れるのは、そういう理由からである。そして、量子化学シミュレーションでは一般的に、化学的精度が要求されるので、量子計算機に求められる忠実度のハードルも高い。

量子シミュレーションにおける量子優位性の実現ハードルは、量子物理シミュレーションは低い(早期に達成する可能性がある)が『実用的な』量子アプリケーション探索・開発には直結していない。量子化学シミュレーションは『実用的な』量子アプリケーション探索・開発に直結するが、量子優位性の実現ハードルは高い。

【7】ステージⅣ|ユースケースのための最適化・コンパイル及び量子リソースの推定

(0) 定義及び射程

㈠ ステージIVでは、理論的な高速化から、特定のユースケースに向けた最適化、コンパイル、および量子リソース(資源)の見積りといった実用的なエンジニアリング課題へと焦点が移る。これは、これまでのステージとは大きく異なる点である。

㈡ ステージ IV には、論理回路を量子誤り訂正符号にマッピングするためのコンパイラーの開発、および Qualtran(グーグル)、Q#(マイクロソフト)、QREF(米Psi Quantum) 、Bartiq(Psi Quantum)、Qrisp(独フラウンホーファー研究所・ベルリン自由大学)、Silq(グーグル)等のリソース見積りを自動化および合理化するように設計されたソフトウェア・ツールの作成が含まれる。

(1) ステージIVにおけるケーススタディ

割愛。

(2) 最終的なリソースの推定

誤り耐性が初期の段階にある時点では、量子アルゴリズムと量子誤り訂正(QEC)アーキテクチャの詳細を共同設計することが極めて重要になる。最終的なリソースの推定は、選択されたQECアーキテクチャと、アプローチを真に差別化するために必要な詳細なコスト・モデルに大きく依存する。初期誤り耐性におけるコストを詳細に理解するには、特定のアーキテクチャへの完全なコンパイルが必要になる可能性が高いだろう。今後数年間、精密なコンパイル・スタックの構築は、産業界の取り組みの主要な焦点となると予想される。

【8】ステージⅤ|量子アプリケーションのデプロイ

(0) 定義及び射程

㈠ ステージVは、実証済みの量子アプリケーションを実用的なワークフローに導入する段階である。現時点では、実世界に影響を与える問題に対して決定的な優位性を持つ量子アプリケーションがハードウェアに実装されていないため、この段階は完全に将来的なものである。導入の動機は、基盤となる技術が量子であるという事実に依存せず、それが当該の問題またはアプリケーションに対するより優れたソリューションであるという事実に完全に依存することである。

㈡ おそらく現在最も近い例は、認証済み乱数生成❚補足8❚であるが、その影響は現時点では限定的である(と本PPは述べている)。

㈢ ステージVでは、業界固有のアプリケーション・プログラミング・インターフェース、環境、ワークフローの作成が伴う可能性がある。例えば、クライアントがタスクを量子コンピュータにシームレスにオフロードできるクラウドサービスなどが挙げられる。

❚補足8❚

米大手商業銀行JPモルガンチェース他は、「商用量子コンピューターを使用して、Certified Randomness(保証されたランダム性)を生成することに成功した」と発表した(25年3月26日)。詳細は、こちらを参照。

【9】追補

(1) XPRIZE量子アプリケーション・コンペティションーファイナリスト7者

慶應義塾大学の研究者は、「量子アルゴリズムを代謝経路解析に初めて適用した」と主張する論文(以下、本論文[*A-100])を発表した(25年10月27日@biorxiv)。なお、量子アルゴリズムは、NISQ実機ではなく、量子シミュレーターを使って実行された。

【1】本論文の主張

本論文は、以下を主張する:

(1) 生物学分野において量子コンピューティングに適したユースケースを特定した。

(2) QSVT(☞【2】(3))を適用する上でネックとなる、条件数を削減する手法を開発した。

(3) (2)手法をFBA解析(☞【2】(1))に実施し、解が正しく収束することを示した。

【2】事前整理

(1) フラックス・バランス解析[*A-101],[*A-102],[*A-103]

0⃣ 前説

細胞が行っている諸々の生産活動は、一連の連続した化学反応と見做すことができる。この化学反応⋍代謝を評価するには、フラックスを導入することが有用である。フラックスは様々な分野・文脈で使われる便利な概念であるが、生物学の文脈においてフラックスとは、「単位時間・単位細胞量あたりの反応速度」と定義される。なお、「一連の連続した・・・」は、ネットワークと見做すことができるので、一連の連続した化学反応は、化学反応ネットワークと言い換えられる。細胞における、この化学反応(⋍代謝)ネットワークは、代謝経路と呼ばれる。細胞の全代謝経路は、数百~数千個の化学反応からなる複雑なネットワークとされる。

1⃣ 概要

代謝経路のフラックス分布を調べる方法全般は「代謝フラックス解析」と呼ばれ、様々な種類が存在する。最も広く使われている代謝フラックス解析は、米カリフォルニア大学サンディエゴ校の研究者が開発したフラックス・バランス解析(FBA)とされる。代謝物の濃度が時間とともに変化しない定常状態を仮定している。最も広く使われている理由を化学の観点から説明すると、「詳細な反応速度論の情報なしに、反応の化学量論の情報だけから予測が可能」という説明が可能であろう。また、よりシンプルに、「大胆に簡略化🐾1されていながら、実験結果と良い一致を示す🐾2から」という説明も可能であろう。

🐾1 反応速度論を無視していることに加えて、物理(熱力学)も無視している。

🐾2 これは、「目的関数の設計が優れているから」、という説明が可能であろう。

2⃣ 定式化

FBAを数理的に規定すると、目的関数を最大化(あるいは最小化)する最適化問題、と規定することができる。細胞増殖の最大化が目的関数として、よく用いられている🐾3。代謝フラックス解析は常微分方程式系で記述されるが、定常状態を仮定しているFBAでは連立一次方程式系で記述することが可能である。そのため、最適化問題と見做したFBAは一般に、線形計画問題(凸最適化問題)として定式化できる。線形計画問題を解く場合、算術的には逆行列の計算が発生する。この逆行列計算に計算コスト上の課題があるため、FBAには、新たなアルゴリズムが必要と本論文は主張する。

🐾3 生物の代謝状態は進化の過程を経て、自身の細胞増殖を最大化するように自己調節されているという仮定に基づく。

(2) 内点法及び量子内点法

n 次元行列の逆行列を求めるコストは、最良の古典アルゴリズム(内点法🐾4)でも O(n3) である。ただし、このコストは、疎行列の共役勾配法を用いることで O(n・s・κ) まで削減できる。ここで、s は疎性、κは条件数🐾5である。

量子アルゴリズム=量子特異値変換(QSVT)を使った量子内点法(QIPM)🐾6の場合は、O(κ2log(κ/ε)・log(n))🐾7である。つまり、量子内点法の場合ーより正確に言うとQSVTの場合ー、条件数がボトルネックとなる。CAE(Computer Aided Engineering)の分野では、しばしば有限要素法における逆行列計算への量子線形ソルバー(QLS)適用という文脈で、QSVTは条件数がネックとなり、現実的には使えない、という評価が成されている。そのような逆風下で、本論文は、条件数を減らすための工夫を凝らしている(☞【3】(2))。

🐾4 内点法(IPM)は、凸最適化問題を解くために広く使用されている効率的な古典アルゴリズムである。FBAは凸最適化問題であった。

🐾5 解くべき問題は、連立一次方程式系「係数行列A×未知である解ベクトルx=既知のベクトルb」として定式化される。このとき、係数行列Aに対して定められる「当該問題を、数値的に解くことが適切か否か」を判定する指標が、条件数である。条件数が小さければ、良条件(数値的に解くことが適切)である。

🐾6 QIPMは、QLSを用いて凸最適化問題を解くことを目的とする。本論文では、QSVTに基づく量子線形ソルバーを用いる。

🐾7 εは、許容誤差である。

(3) 量子特異値変換(Quantum Singular Value Transformation : QSVT)

1⃣ 基礎的なお話

様々な量子アルゴリズムが知られているが、それらの統一的理解は可能か?という問いは、量子アルゴリズム理論における重要な未解決の問題である。QSVTは、量子特異値変換という枠組みにより、統一的な理解🐾8を可能にしてくれる[*A-104]。

QSVTは、「大自由度系のQSP(量子信号処理)🐾9」と捉えると理解し易い(旨が、[*A-105]に書かれている)。つまりQSVTは、1量子ビットの場合に定義されるQSPを、各特異値に対応する部分空間で行う量子アルゴリズム、と言える。本質的には、QSVTはQSPで説明できるので、以下QSPについて整理する。

QSPという量子アルゴリズムは、2種類の1量子ビット回転ゲートを交互に作用させるユニタリ演算子(≒行列)として表現される。QSPの何が嬉しいかというと、行列要素に、一定の制約はあるが任意の多項式P(・)を生成させることが可能という点である。回転角をパラメータとして、効率的に多項式を生成することができる。ただし、効率的かどうかは、条件数に依存するのであった。

2⃣ QSP⋍QSVTを使った逆行列計算

QSVTの応用先は多岐に渡るが、ここでは逆行列計算を特出しして、取り上げる。なお、QSPでは”大自由度”である行列は扱えないため、逆行列計算には、QSPではなくQSVTを適用することになるが、本質的な議論は変わらないので、敢えて混同して、議論を進める。

行列Aを特異値分解して、∑λi|λi⟩⟨λi|と表記する(i=1~N)。このとき逆行列A-1は、特異値🐾10の逆数で展開した∑λi-1|λi⟩⟨λi|と表記できる(i=1~N)。それらを多項式P(・)とみなすと、それぞれP(Λ)とP(Λ-1)のように表すことができる🐾11。ここでΛは対角要素がλiである対角行列、Λ-1は対角要素がλi-1である対角行列である。プロセスで説明すると、以下のようになる:まず、行列A=P(Λ)を、(もちろん別の行列の、行列要素として)準備する。次に、パラメータである回転角を操作して、P(Λ-1)を生成すると、それは、逆行列A-1を(別の行列の)行列要素として生成させる、ことにつながる。量子演算っぽく言うと、量子状態準備→ユニタリ変換→測定して取り出し、ということになるだろうか。なお、正確にはP(Λ-1)の近似多項式を生成しているわけので、Aの逆行列A-1ではなく、Aの擬似逆行列を構成していることになる。

いずれにしても、アルゴリズム論的には『効率的に生成できる』という箇所がポイントとなる。つまり、多項式を効率的に生成できるという利点が、逆行列を効率的に生成できるという利点に昇華したことになる。ただし、重複するが、効率的かどうかは、条件数に依存するのであった。

🐾8 [*A-106]には、「量子アルゴリズムの大統一理論と呼ばれ・・・」という記述がある。

🐾9 元々は、核磁気共鳴における信号強度の増幅を目的として提案された技法らしい。

🐾10 行列Aが正方行列である場合、特異値=固有値である。なお、QSVTは、Aが正方行列でなくても適用可能である。

🐾11 QSPではP(Λ)は扱えない。QSVTでは扱える。QSPはP(λ)なら扱える。ここでλは、任意のiについて固定したλiの意味である。

【3】本論文の技術的要素

(1) 本論文における課題解決に至るまでのフロー概要

改めて、フローを簡潔に述べると、以下のようになる:FBA=最適化問題を線形計画法(量子内点法)で解く。量子内点法で解く場合、逆行列の計算は必須である。逆行列の計算には、量子特異値変換(QSVT)を用いる。QSVT の計算上のボトルネックは、逆行列の条件数に依存する。このため、条件数を減らすべく、工夫を凝らす。それが、「行列Aのヌル空間射影に正則化を加えることで、条件数を削減する方法」である。

(2) 行列Aのヌル空間射影に正則化を加えることで、条件数を削減

0⃣ 能書き

単純な正則化戦略は、行列 A に対角項 αI を追加することである(αはスカラー、Iは恒等行列)。ただし、この単純な戦略では、Aとの対比で大きな αを使用することなしに、条件数κを削減することはできない。大きなαを使用することは、大きな擾乱を導入することと同義であるから、精度の低下を招く。そこで、本論文で採用している戦略は、行列Aを良い感じに調整した上で、正則化項を導入するという手法である。良い感じとは、条件数を削減しながら、大きなαを導入しても精度が落ちない、という”かなり都合の良い”感じを指している。

1⃣ 概要

具体的には、行列Aに射影演算子℘を掛けることで、行列を調整している。なお、本論文の設定(FBA解析という最適化問題を線形計画法で解く)場合、該当する行列はヘッセ行列Hとなる。射影演算子℘として、ヌル空間への射影演算子を採用すれば、最適化問題を構成する方程式は、シンプルになる。注意すべき点は、「ヌル空間への射影演算子であれば自動的に、いい感じになるわけではない」ということである。あくまで、ヌル空間は、方程式をシンプルにするだけである(と理解)。ちなみに、本論文の設定におけるヌル空間は、化学量論行列 S のヌル空間ということになる。

2⃣ 数式もどきの結果

結果を数式もどきで書くと、H×●+〇=▲+△が、(℘H℘+αiI)×●=℘▲という形に変形される。Hはヘッセ行列、℘はヌル空間への射影演算子である。解くべき方程式は、全体的にシンプルになっている→〇と△が=0になるように℘が選ばれている。Hが℘H℘に調整され(ヌル空間に射影され)、さらに正則化項 αiIが導入されている。ここで、添え字iは、i番目の反復における正則化を意味している。●は求めるべき解vの増分である。つまり、vi+1= vi+●、という形で反復的に解が更新される。

上述のような変形を行うことで、「ヌル空間に射影されたヘッセ行列は小さくなるが、密(denser)になり、正則化に対する応答が改善され、アルゴリズムがより安定して正確になる」と本論文は主張する。

3⃣ 補足

vi+1= vi+●、という解の更新は、厳密に言うと、vi+1= vi+β×●という形式で行われる。 βはαに依存して異なる値を採る。具体的には、α > 0.1 の場合は β = 0.2、α = 0.1 の場合は β = 0.7、α < 0.1 の場合はβ = 1.0となっている。

【4】比較結果、評価結果

(0) セットアップ

細胞エネルギー代謝の2つの中心的な経路である解糖系🐾12とトリカルボン酸(TCA)回路🐾13からなる炭素コア経路において、本手法を検証した。化学量論的行列Sは22×20次元を持ち、(量子シミュレーター🐾14を使った)シミュレーションには6量子ビットを使用した。目標は、バイオマス生産量を最大化するフラックスを見つけることである。

🐾12 解糖系(glycolytic pathway)とは、細胞内に取り込まれたグルコースが、ピルビン酸あるいは乳酸に代謝される代謝経路である。

🐾13 トリカルボン酸回路(TriCarboxylic Acid Cycle)とは、細胞内のミトコンドリアで、酸素を用いて炭水化物、脂質、たんぱく質を水と炭酸ガスに分解し、エネルギー物質のATPを生産する代謝経路。クエン酸回路(Citric Acid Cycle)あるいはクレブス回路(Krebs Cycle)とも呼ばれる。

🐾14 加ザナドゥが提供するPennylaneには、追加のインストールなしで利用できるデフォルトのシミュレーターが含まれている。そのデフォルト・シミュレーターが使用された。ザナドゥは、光方式の量子コンピューターを開発しているスタートアップ。スタートアップではあるが、NASDAQ及び加トロント証券取引所にSPAC上場することが、25年11月3日に決定・承認された。Pennylaneは、ザナドゥが開発・提供している、オープンソースの量子ソフトウェア・フレームワーク。量子機械学習の分野では、特に評価が高い(デファクト・スタンダードになっている)。

(1) 本論文で開発した手法により導出した解が、古典解🐾15に収束する。このことをもって、本論文で開発した手法は、FBA解析において、正常に機能にしている、と結論している。

🐾15 IPMを使って解いた解と思われる。

(2) 条件数が実際に削減している様子が示されている。反復回数(0~2,000)によって異なるが、本論文の手法を使うと、条件数は、およそ1~およそ100である。本論文の手法を使わない場合、およそ500~およそ1億である。桁違いということになる。

【5】考察

アーロンソン・アンバイニス予想は、何らかの構造を持たない決定問題で指数加速は実現しないだろう、と予想する。量子アルゴリズムに統一的な理解をもたらすと期待されるQSVTは、1量子ビット回転ゲートを操作するだけで、効率的に多項式を生成することが、量子加速の源である。ただし、条件数がボトルネックになる。本論文は、ボトルネックである条件数を削減する手法を提案している。

本論文の手法が、なぜ劇的に条件数を減らせるのか、正しく理解できていないが、全ての問題に適用可能というわけではないだろう。適用可否は、問題に潜在する何らかの構造に依存しているのであろう。

誇大宣伝との批判が多い量子コンピューティング界隈でも、金融と医療は常に、(良くも悪くも)スポットライトを浴びてきた。中でも、創薬を含む医療周辺技術分野は、量子コンピューティングへの期待が、(国家レベルで)大きいように思われる。例えば、英国立量子コンピューティングセンター(NQCC)は、「量子コンピューティングが、医療と製薬分野を変革する現状、短期的な機会、そして将来の可能性について考察」した『量子コンピューティングによる医療と製薬の融合:医療の新たなフロンティア』というレポート[*N-8]を25年3月に発表している。同レポートでは、量子コンピューティングを、「創薬、個別化医療、臨床試験の最適化、医用画像、医療ロジスティクス」に飛躍的な変化をもたらす可能性を秘めた技術である、と紹介している(☛こちらを参照)。

米レンセラー工科大学他🐾1の研究者は、「量子技術が医薬品イノベーションに、どのような変革をもたらすか」を探った論文(以下、本論文[*N-9])を発表した(26年1月7日@npj drug discovery)。ちなみにレンセラー工科大は、世界で初めて(2024年4月)、大学のキャンパス内に「IBM Quantum System One」を設置した大学である。

本稿は、医薬品開発サイクル全体にわたり、量子コンピューティングがどのような事業機会を創出するか?という視点で本論文を再構成した。

🐾1 米イリノイ大学アーバナ・シャンペーン校、米ピッツバーグ大学、米パデュー大学、ノボ・ノルディスク(デンマークの製薬企業)→IBM Quantumに転職、米ハーバード大学、米シカゴ大学。

【1】医薬品候補物質探索における量子コンピューティングの事業機会

(0) そもそもの整理・・・

❒ 量子コンピューティングの対象は、量子化学シミュレーションと量子最適化である。

❒ 量子化学シミュレーションがもたらす事業機会は、計算の高速化ではなく、精確な予測あるいは設計である。従って、NISQでも実現は可能である。ただし、NISQでは扱える問題サイズが小さいため、事業機会は限定的である。

❒ FTQCにより実現が期待される量子加速による事業機会の創出を否定しないが、FTQCには、「これまで解けなかったサイズの問題を(精確に)解く」という事業機会の創出への期待が大きい。

❒ 量子最適化に対する量子加速の期待は、元々、小さい(一般的な最適化問題において、指数加速を実現する量子アルゴリズムは存在しないと考えられている)。量子最適化がもたらす事業機会は高速化ではなく、「高い精度を維持しながら、効率的に医薬品候補物質を探索すること」である。

❒ 創薬プロセスとしては、リード最適化までを対象としている。

❒ モダリティは、低分子化合物である。

(1) タンパク質結合部位

1⃣ 事業機会

金属タンパク質におけるタンパク質結合部位の予測。精確に予測することで、医薬品候補物質が上市に至らない確率を低減させる、という価値をもたらす。これは、(臨床試験を含めた)創薬プロセス全体わたる、時間と費用の大幅な削減に繋がる。

2⃣ メイン

標準的な若しくは固定電荷力場🐾2を使うモデル(古典アプローチ)では、金属タンパク質🐾3のように「微妙な電子効果に支配される」結合部位の解析は困難である。一方、量子アプローチは、明示的な電子ハミルトニアンを介して、「微妙な電子効果に支配される」結合部位の解析を可能にする。

ただし、現状の量子アプローチは、量子ハードウェアがNISQマシンであるため、制限されている。具体的に言えば、量子誤りへの対応・対処が量子誤り緩和(QEM)に依存しているNISQマシンでは、小さな活性空間しか扱えない。現時点では、誤り耐性量子コンピューター(FTQC)が利用可能となるまでの繋ぎとして、量子と古典の”いい所取り”をした量子古典ハイブリッド・モデルが利用されている。

👔為参考👔 水和部位予測に関しては、こちらを参照。

🐾2 原子を静電荷を持つ点として近似する力場モデル。

🐾3 タンパク質の約1/3が金属を必要とするか、金属と結合するため、金属タンパク質は一般的である。

3⃣ 為念:古典から量子への高速化

㈠ NISQ

分子構造シミュレーションにおいて、VQE(変分量子固有値ソルバー)は理屈上、多項式時間で基底状態のエネルギーを計算できる、とされる。量子多体系における基底状態エネルギーの古典計算は、一般には指数時間を要する(多項式時間では解けない)と考えられているので、指数加速になる。ただし、VQEには不毛な台地という固有の問題が存在し、不毛な台地を回避できる場合は、古典計算で効率的にシミュレートできるとされる。従って、現実的には指数加速は期待できないという意見が、コンセンサスと思われる(→故に、FTQCが必要と考えられている)。古典計算は、特定のケースにおいては、様々な工夫を施すことで、指数時間を回避している。

QITE(量子虚時間発展アリゴリズム)は、多項式時間でプロトンの移動シミュレーションが可能である。つまり、指数加速が実現する。

㈡ FTQC

分子構造シミュレーションにおいて、QPE(量子位相推定法)は、指数加速をもたらす。

(2) 結合エネルギー

1⃣ 事業機会

タンパク質-リガンド結合における結合エネルギーの予測。精確に予測することで、医薬品候補物質が上市に至らない確率を低減させる、という価値をもたらす。これは、(臨床試験を含めた)創薬プロセス全体わたる、時間と費用の大幅な削減に繋がる。

2⃣ メイン

タンパク質-リガンド(低分子化合物)の結合様式と親和性の予測は、依然として、創薬における中心的な課題である。古典アプローチは、「電子相関の複雑な瞬間的相互作用、結合時の動的分極🐾4による分子の歪み、異なるプロトン化の微妙なエネルギー特性」等を捉えることに課題を抱えている。この課題に対してNISQベースでは、変分量子アルゴリズム(VQA)や量子虚時間発展アルゴリズム(QITE)が用いて解決が図られる。FTQCでは、量子位相推定(QPE)及び量子振幅推定(QAE)が、量子アルゴリズム・プリミティブとして用いて解決が図られる。

同じく、現状の量子アプローチは、量子ハードウェアがNISQマシンであるため制限されている。現時点では、誤り耐性量子コンピューター(FTQC)が利用可能となるまでの繋ぎとして、量子と古典の”いい所取り”をした量子古典ハイブリッド・モデルが利用されている🐾5。

🐾4 溶媒の揺動のために時間に依存して変化する分極構造を指す。

🐾5 本論文では、量子古典ハイブリッド・モデルが、βセクレターゼ阻害剤の予測を成功させた例があげられている。βセクレターゼは、アミロイドβペプチド前駆体タンパク質のN末端側を切断する酵素である。N末端の切断により、アミロイドβペプチドが産生される。つまり、βセクレターゼ阻害剤は、アミロイドβペプチドの産生を抑制する(ことで、アルツハイマー型認知症の発症を抑制することが期待される)。

3⃣ 為念:古典から量子への高速化

㈠ NISQ

QITEは、水素結合における結合エネルギー計算で、指数加速を実現する。

㈡ FTQC

QPEは、水素結合に限定されずに、結合エネルギー計算で指数加速を実現する。QAEはサンプリングにおいて、2次加速を実現する。

(3) リガンド生成

1⃣ 事業機会

標的タンパク質との相互作用に必要な「特定の電子特性を持つ」リガンドの設計。的確に設計することで、医薬品候補物質が上市に至る確率を高める、という価値をもたらす。これも、(臨床試験を含めた)創薬プロセス全体わたる、時間と費用の大幅な削減に繋がる。

2⃣ メイン

古典アプローチは、グラフ・ニューラルネットワークと拡散モデル(結合相互作用・生成拡散モデル(BInD)❚補足1❚)を通じて、構造ベースの新規低分子化合物を生成する。量子アプローチでは、多目的最適化問題を解く❚補足2❚ことで、標的タンパク質の結合部位内での(リガンドとの)相互作用に最適化された、新規のリガンド(低分子化合物)を生成する❚補足3❚。例えば、QAOA(近似的量子最適化アルゴリズム)を用いて、量子力学的精度を維持しながら、立体配座空間を効率的に探索する。本論文では、「QAOAは、結合に不可欠な電子特性の最適化に優れている」と紹介されている。一般的な最適化問題において、指数加速を実現する量子アルゴリズムは存在しないと考えられている。従って、最適化問題を解くというアプローチであれば、FTQCが導入されても意味はない。

言わずもがな、リガンド生成においても現状の量子アプローチは、量子ハードウェアがNISQマシンであるため制限されている。このため、量子古典ハイブリッド・モデルが利用されている。

3⃣ 為念:古典から量子への高速化

㈠ NISQ

QAOAは多項式加速をもたらす、とされる。ただし、古典ヒューリスティクスとの比較で優位性をもたらすことは保証されていない。

㈡ FTQC

特定の構造を持つ場合を除いて、一般の最適化問題において、指数加速は実現しないと考えられている(アーロンソン・アンバイニス予想から導かれるだろう)。

❚補足1❚ BInD[*N-10]

BInD(Bond and Interaction-generating Diffusion)は、構造ベース創薬(SBDD)🐾6のための深層生成アプリケーションであり、好ましい形状とタンパク質-リガンド相互作用を持つ分子を生成する。分子の形状や化学的性質のみに焦点を当てた従来の逆拡散モデルとは異なり、BInDは分子の原子、結合、そして標的タンパク質との非共有結合性相互作用(NCI)🐾7を同時に生成する。標準的な逆拡散法は、有効な分子が出現することを予測し、原子と位置のみのノイズ除去を行う。

BInDは、化学知識制約と動的タンパク質-リガンド・グラフ推論を適用しながら、分子とタンパク質との相互作用エッジ(グラフの辺)のノイズを、共同で除去することで、この手順を拡張する。こうすることでBInDは、「相互作用の忠実度が、化学的妥当性と同様に重要」となるSBDDに、より適した手法となる。

🐾6 標的タンパク質の「3次元構造」(が既知であること)を前提として、標的タンパク質と医薬品候補物質との相互作用の情報を利用して行う創薬。SBDD以前は、リガンド・ベースの創薬(LBDD)が行われていた。LBDDの使える情報はは2次元情報(化学式)に留まる一方、SBDDでは3次元情報(3次元構造)を使えるとことに優位性がある、とされる[*N-11]。

🐾7 具体的には、静電的相互作用、水素結合、芳香環相互作用、ファンデルワールス力などがある。

❚補足2❚

リガンドと標的タンパク質間の最適な結合構成を特定する問題は、最適化問題にマッピングすることができる。つまり、分子ドッキング問題を組み合わせ最適化問題(離散最適化問題)として捉えることができる。

離散最適化問題に適用される量子アプローチ及び量子に着想を得たアプローチには、量子ウォーク、シミュレーテッド・アニーリング法、量子ヒューリスティックスが上げられる。量子ウォークは2次加速をもたらす、とされる(エンドツーエンドで、どの程度の加速が実現できるかは不明)。シミュレーテッド・アニーリング法は、どの程度の加速が実現できるかは不明。

量子ヒューリスティックスには、 変分量子アルゴリズム(VQA)、量子アニーリング法、QAOAが上げられる。全て、どの程度の加速が実現できるか、実際には不明である。

❚補足3❚

米の量子S/WスタートアップPolarisQB(Quantum Biotech)は、リガンド生成において量子アニーリング法🐾8とBInDを比較し、次の結果を得た、発表した(25年11月6日@ChemRxiv[*N-10(再)])。BInDは量子アニーリングと比較して大幅な多様性を示した。一方、量子アニーリングは標的タンパク質結合部位に、より(more)最適化された特性を示した。結合親和性、ドラッグ・ライクネス(薬らしさ)、及び相互作用の忠実度は、量子アニーリングが優れていた。

🐾8 つまり、量子アニーリングで多目的最適化問題を解いている。PolarisQBは、昔からアニーリング技術を積極的に活用している。かつては、富士通の擬似量子アニーリング・マシン(ソフトウェア・ベースの量子アニーリング・マシン)を使っていた。少なくとも2023年には、D-Waveの量子アニーリング・マシンに変えている。

【2】臨床試験における量子コンピューティングの事業機会

(0) そもそもの整理・・・

❒ 量子コンピューティングの対象は、量子機械学習と量子最適化である。

❒ 臨床試験における量子機械学習は、主にクラス分類(クラスタリング)である。

❒ デジタル・ヘルスにおける体系的な評価では、これまでのところ、量子機械学習が古典機械学習に対して、一貫して優れているという結果は得られていない。量子機械学習を用いた量子コンピューティングによる事業機会は、微妙と考えられる。

❒ 臨床試験における量子最適化は、多目的あるいは複数制約条件を持つ最適化問題である。

❒ 量子最適化に対する量子加速の期待は、元々、小さい(一般的な最適化問題において、指数加速を実現する量子アルゴリズムは存在しないと考えられている)。量子最適化がもたらす事業機会は高速化ではなく、複数の適切な評価基準(マルチ・スコア)を指標とした、より的確な最適化の実現である。

(1) 治験実施施設の選定

1⃣ 事業機会

多目的の組み合わせ最適化問題(離散最適化問題)を、(古典手法)より的確に解く。臨床試験に要する時間と費用を削減することが期待できる。

2⃣ メイン

臨床試験計画において、適切な治験実施施設の選定は、 以下に示すような多くの複雑な実務的要因のバランスを取らなければならない、複雑な最適化問題として扱われる(適応型試験設計は、さらに複雑である):㊀広範な地理的カバレッジの確保、㊁高い患者募集率の達成、㊂関連する専門知識を持つ治験責任医師の雇用、㊃治験実施施設開設のための規制上の期限遵守、㊄コスト管理。この最適化問題に対する古典アプローチには、混合整数計画法(MIP)や古典メタ・ヒューリスティック・アルゴリズム等がある。古典メタ・ヒューリスティックスには、遺伝的アルゴリズムやシミュレーテッド・アニーリング法などがある。

量子アプローチには、量子アニーリング法や QAOA等がある。NISQマシン上で実行されるQAOAは、量子古典ハイブリッド・アルゴリズムである。

3⃣ 為念:古典から量子への高速化

QAOAは、古典ヒューリスティクスとの比較で優位性をもたらすことは保証されていない。量子アニーリング法は、加D-Waveのハイブリッド・ソルバーを用いて検証されているが『エンド・ツー・エンドでの優位性は、まだ示されていない』。

(2) 臨床試験データ管理

1⃣ 事業機会

複数の制約条件を跨いだ同時最適化問題を、(古典手法)より的確に解く。臨床試験に要する時間と費用を削減することが期待できる。

2⃣ メイン

金融分野で用いられているポートフォリオ最適化では一般に、複数の異なる目的や複数金融資産のバランスに対して、同時最適化が実行される。この同時最適化を実現する技術は、臨床試験データ管理にとっても有用である。臨床試験データ管理の文脈では、「(患者あるいは施設の)地理的分布、患者の人口動態、施設の能力」といった複数の制約条件を跨いだ同時最適化が、ポートフォリオ最適化のテクニックを用いて実行される。

ポートフォリオ最適化の同時最適化は、量子技術を使うことで、最適化の精度が上がることが期待されている。臨床試験データ管理における同時最適化も、同じことが期待されている。臨床試験データ管理の場合は、試験パラメータが、ハミルトニアンに符号化される。その後、イジング・モデルとして表現し量子アニーリング法を適用する、若しくはQAOAを適用して、最適化問題が解かれる。その際、古典解で初期化(ウォーム・スタート)すると、最適解に到達するために必要な量子演算回数を削減できる可能性がある、とされる。

3⃣ 為念:古典から量子への高速化

どの程度の加速が実現するかは、実際には不明である。

(3) 臨床試験リソース配分

1⃣ 事業機会

動的状況下におけるリソース配分最適化で、(古典手法)より的確に解く。臨床試験の効率(Risk Adjusted Return on Resource)向上が期待できる。

2⃣ メイン

臨床試験リソース配分の最適化における要諦は、リスクと付加価値に応じて、リソース配分をコントロールすることらしい。つまり、リスクが高いタスクに対しては厚めのリソースを割り当て、低リスク・タスクに対しては可能な限りリソースを省く。高付加価値タスクには、リソースを多く割り当て、低付加価値タスクには、リソースを割かない。

臨床試験リソース配分は従来、数理最適化手法を使って最適化されていたが近年は、強化学習が適用され始めている。動的な状況での最適化には、強化学習が適するとされる。臨床試験のリスクは動的に変化するため、強化学習を使ったリソース配分が適すると考えられる。量子技術を活用した量子強化学習は、リアルタイムの最適化及び意思決定を必要とするシナリオにおける臨床試験リソース配分に対して、特に有効であることが実証されている(らしい)。

3⃣ 為念:古典から量子への高速化

エージェントと環境の両方を量子系とする、完全な量子強化学習でも、2次加速しか発見されていない。

(4) コホート層別化

1⃣ 事業機会

精確な層別化を介した、(第3相臨床試験の)無作為化比較試験の精度向上。第3相臨床試験に要する時間と費用の削減が期待できる。

2⃣ メイン

無作為化比較試験(並行群間試験:randomized clinical trials)は、標準治療を行うグループ(対照群)と新治療を行うグループ(治療群)に、被験者をランダムに振り分けて治療を行なう。無作為化比較試験では、主要評価項目(プライマリー・エンドポイント)に影響を与えると考えられる(予め定められた)要因に関して均等化を行うことで、群間の被験者像を揃える。これを(コホート)層別化と呼ぶ。従来、層別化は統計的手法(単純な統計モデル)を使って行われてきた。しかし、医療データは変数間に複雑な依存関係があるため、 単純な統計モデルで精度が高い層別化を実行することは難しい、とされる。そこに、機械学習モデルを活用する余地が生じる。

機械学習を使った層別化は、(機械学習で言うところの)クラス分類を利用することで、可能になる。クラス分類(クラスタリング)に使われる機械学習モデルとして、k-近傍法、(ランダムフォレストを含む)決定木系、サポートベクターマシン(カーネル法)などがある。量子化を鑑みると、サポートベクターマシン(カーネル法)が選択される。臨床試験データは、ゲノムデータ・臨床データ・画像データというように、データ・モダリティが複数である。さらに、ゲノムデータと臨床データ間には、強い相関があると考えられる。量子カーネル法は、そのような状況における層別化に、特に有効であると考えられている。

3⃣ 為念:古典から量子への高速化

特定の分類タスクにおいて、2次加速が実現する。量子カーネル法における特徴量マッピングでは、指数加速が実現する(らしい)。

(5) 連合学習

1⃣ 事業機会

データ処理の効率化。プライバシー保証の強化。機械学習モデルを強化する。

2⃣ メイン

量子連合学習(QFL)は、量子機械学習(QML)モデルを用いることで、複雑な高次元臨床データを古典手法よりも効率的に処理することで、連合学習❚補足4❚のパラダイムを強化する。量子力学の本質的なランダム性は、差分プライバシーと統合することができる。これにより、必然的にノイズが生成され、より強力なプライバシー保証が実現する。QMLモデルは高次元臨床データの処理において顕著な効率性を示し、マルチモーダル量子混合専門家🐾9(MQMoE)フレームワークは、異種医療データセットの処理において大きな利点を示している(らしい)。

🐾9 混合専門家(エキスパート):MoEの概念は古くから存在する。元のモデルを、小規模な部分ネットワーク(=エキスパート)に分割し、エキスパートが協働してタスクを実行する、という機械学習アプローチ。コストを抑えながら高い性能を引き出すことが可能とされる。エキスパートは各々が、入力データの特定部分セットに特化している、あるいは特定タスクに特化している(つまり、専門家)。

3⃣ セキュリティ

㈠ 攻撃の検知

臨床試験データのセキュリティは、量子強化検出システムから大きな恩恵を受ける。量子カーネル法は、医療センサーデータに対するラベル・フリッピング攻撃🐾10の検出精度が、75~95%に達しており、古典アプローチを大幅に上回っている。これらの量子攻撃検知システムを連合学習フレームワークと統合することで、複数の試験施設にまたがる微妙な改ざんパターンを識別できる堅牢なセキュリティ基盤を構築できる。

🐾10 (悪意のある)攻撃者が、データ内のラベルを操作し、正しいラベルと誤ったラベルを交換する、という攻撃。

㈡ 暗号化

ブラインド量子コンピューティング🐾11や耐量子暗号等は、暗号化されたデータに対する安全な計算を可能にすると同時に、将来の量子脅威に対する長期的な保護を確保する。これらのアプローチをマルチモーダルQFLと組み合わせることで、安全かつプライバシーを保護した臨床試験データ分析のための包括的なフレームワークが構築される。この量子-古典ハイブリッドアプローチにより、計算効率と厳格なプライバシー基準を維持しながら、試験データのリアルタイム・モニタリングが可能になる。

🐾11 秘匿性を保ったまま行う、委託量子計算を指す。

4⃣ 為念:古典から量子への高速化

通信において、指数加速が実現する。

❚補足4❚

機械学習でデータが不足している場合には、データ拡張、転移学習、連合学習といった対処法が採られる。連合学習は、2017年にグーグルが提唱した概念である。連合学習では、データは集約しない。分散しているデータを分散したままマージして、学習を行う。データが足りなければ(どこかにはあるので)、集めて増やせば良いという発想である。学習モデルという観点からは、「アンサンブル学習と事前学習済モデルの組み合わせ」という見方もできる(と理解している)。

(連合学習は金融などでも用いられているが、)創薬の分野では、2019 年から開始された欧州のMachine Learning Ledger Orchestration for Drug Discovery(MELLODDY)コンソーシアムが有名である。データの秘匿性を保持しながら 1,000 万を超える低分子化合物のデータを共同利用できる枠組みを活用して、有望な医薬品候補物質の予測プラットフォームを構築することを目指している。日本では、AMED創薬支援推進事業「産学連携による次世代創薬AI開発」がある。化合物―生体分子親和性予測AI、化合物構造発生AI及びオミクス情報に基づく標的予測AIの開発を目的としている。連合学習の課題としては、「通信コストが高い、計算時間が長い、プライバシーの懸念」等が上げられている。

ただし、natureの記事[*N-12]によると、「このプロジェクト(MELLODDY)は、公開データセットの状態を改善することに(も)まったく貢献しませんでした」。また、「化学構造と、それらを生成するのに使用されたアッセイの性質を明らかにせずに、データセットを組み合わせるのは非常に困難」とも記述されている。

MELLODDY 意外では、AI Structural Biology Consortiumという取り組みがある[*N-13]。同コンソーシアムは、AIモデルの学習に必要なタンパク質とリガンドの構造に関するデータが限られている、という問題に対処するために設立された。米アッヴィ、独ベーリンガー・インゲルハイム、米ジョンソン&ジョンソン、仏サノフィ、武田薬品が、コンソーシアム・メンバーのようである。タンパク質・リガンド複合体の3次元構造を予測するAIモデルを、独自のタンパク質構造データで学習する。

独Apherisが、「機密を保持したまま、メンバー独自のデータを使って、OpenFold🐾12を再学習する」というフレームワークを提供する。

🐾12 AlphaFold2のオープンソース版。

(6) 合成データの作成

0⃣ 為念:言葉の定義

(本論文の)合成データの作成という文脈において言及されている量子敵対的生成ネットワーク(QGAN)は、量子古典ハイブリッドGAN(HQCGAN)を指している。つまり、生成器が量子回路で、識別器が古典回路(古典的深層学習ニューラルネットワーク)である。

1⃣ 事業機会

モード崩壊の抑制❚補足5❚。データ分析・機械学習を強化する。

2⃣ 医療における合成データへのインセンティブ

罹患者は健常者に比べて少ないのだから、基本的に医療データは、不足している。ましてや希少疾患であれば、なおさらである(女性の医療データも、種々の理由で少ない)。医療機関毎に検査プロトコルは異なるため、同じ疾患に対する検査データであっても、同一視できるとは限らない。医療データを分析や学習用のデータセットとして用いる場合には、匿名化処理して使用されるが、データ難読化やデータ・マスキング等を施す🐾13ことにより、分析や学習に必要な情報が消去される可能性がある。そのようなデータが欠乏した状況下で、さらに特定条件に合致するデータを選択する必要がある。そうしなければ、特定の目的に沿った分析や学習は、実行不可である。

加えて、医療データは厳格に管理されており、その使用承認には、年単位の時間を要することが珍しくない。(管理の厳格さ等を反映して)データへのアクセス・コストも高く、大規模なデータを要する場合には、相応のコストが必要となる。斯様な背景から、医療分野では必然的に、合成データを分析や学習に用いるインセンティブが発生する。

🐾13 簡単な匿名化処理では不十分であることを示した有名な事案として、以下がある:研究目的で公開していた、氏名のみを匿名化処理した医療データから、疾患が特定された(2000年、米マサチューセッツ州知事)。

3⃣ メイン

合成データとは、元データの変数が持っていた統計量や相関性を維持したまま、新規に生成されるデータである。古くから存在する、「適当な統計分布や統計モデルを押し付ける」合成データ生成方法には、そもそも適用限界がある。そこで、機械学習モデルを使った合成データ生成方法が登場した。まず、自己符号化器や敵対的生成ネットワークが適用され、続いて”生成AI”も適用されるようになった。その中で、量子化を鑑みると、敵対的生成ネットワークが選択される。

本論文は、QGANについて、次のような評価を下している:過小評価されている患者カテゴリーにおいて特に有望であり、臨床試験の多様性における重要な課題に対処する。

4⃣ 為念:古典から量子への高速化

QGAN(量子敵対的生成ネットワーク)は指数加速をもたらす、とされる❚補足6❚。同じ精度を達成するために必要な、パラメータ並びに反復回数(イテレーション)は、QGANが少ないとされる。

❚補足5❚

[*N-14]には、以下のような記述がある:HQCGANの主な利点は、量子回路の性質により、本質的に表現力の高い潜在分布を構築できることにある。これにより、生成器はより少ない次元で複雑なデータ分布を捉えることができる。このため、効率的な学習が可能になり、多様性と表現力を犠牲にすることなく、モード崩壊や高次元サンプリング不足などの問題を解決できる。

❚補足6❚

生成器が古典回路の場合、O(N2)。生成器が量子回路の場合、O(poly(log N))[*N-15]。N=exp(log N)なので、log N を改めてnとおけば、古典はO(e2n)、量子はO(poly(n))となる。計算複雑性理論的に言うと、「指数加速」になる。計算複雑性理論は”そういうもの”なので、以下は身も蓋もないが、実際には(Nのサイズは∞ではないので)、どれだけ速くなるかはわからない(本当は、速くならないかもしれない)だろう。

GANの議論は多くの場合、その対象が画像である。その場合、Nのサイズが∞という仮定は妥当かもしれない。医療の場合、画像データ以外のデータも含むので、その仮定が妥当であることを全面的に認めるのは難しいかもしれない。尚、状態準備が効率的でなければ、指数加速は保証されない。

【3】為念:計算資源について

(1) 分子構造シミュレーション

0⃣ 古典コンピューティング

複雑なタンパク質の場合、CPU時間は103~106時間で、スパコンが必要。メモリ使用量は100GB~1TB。

1⃣ NISQ

小さな分子(10 原子未満)に限定。必要とされる物理量子ビット数は50~100 個と推定される。実行時間は、数時間から数日と推定される。高い物理誤り率によって精度が制限される。

2⃣ FTQC

103~104個の論理量子ビットが必要と推定される。実行時間は数分から数時間と推定される。量子誤り訂正により、論理誤り率は無視できるほど小さくなる。

(2) 特性(ADMET🐾14)予測

機械学習モデルの適用を前提としている。

🐾14 ADMET =Absorption(吸収)、Distribution(分布)、Metabolism(代謝)、Excretion(排泄)、 Toxicity(毒性)。

0⃣ 古典コンピューティング

学習は、数時間~数日(1~8GPU)。推論は、m秒~秒/分子、約 105~106/日/GPU。

1⃣ NISQ

現在、実際の分子には実用的ではない。100~500個の物理量子ビットが必要と推定される。

2⃣ FTQC

500~1000 個の論理量子ビットが必要と推定される。実行時間は数時間と推定される。

(3) 薬物標的相互作用

0⃣ 古典コンピューティング

CPU/GPU: 数秒~数分/複合体。機械学習ベースのドッキング予測は、通常数分(AlphaFold3: 数分/複合体)。大規模なクロス・ドッキングの場合はスパコンが必要。

1⃣ NISQ

タンパク質規模の相互作用は、実現可能ではない。数千の物理量子ビットが必要と推定される。

2⃣ FTQC

104~105個の論理量子ビットが必要と推定される。実行時間は数日と推定される。結合ダイナミクスの完全な量子シミュレーションで、量子優位性が実現すると考えられている。

(4) 臨床試験の最適化

0⃣ 古典コンピューティング

分散システムでは数時間から数日かかる。

1⃣ NISQ

小規模な最適化の場合は 100~200物理量子ビットが必要と推定される。実行時間は数分から数時間と推定される。

2⃣ FTQC

500~1000個の論理量子ビットが必要と推定される。実行時間は数分間と推定される。

(5) リード化合物の発見

0⃣ 古典コンピューティング

106~108個の候補を、数時間から数日でスクリーニングする(クラウド/GPU)。

1⃣ NISQ

現在は概念実証に限定されており、物理量子ビット数は100~500個が必要と推定される。

2⃣ FTQC

1000~5000論理量子ビットが必要と推定される。実行時間は数日間と推定される。

(*A-63 O. Lanes et al.、A framework for quantum advantage、https://arxiv.org/pdf/2506.20658)

(*A-65 Hsin-Yuan Huang et al.、The vast world of quantum advantage、https://arxiv.org/pdf/2508.05720)

*A-77 Ryan Babbush et al.、The Grand Challenge of Quantum Applications、https://arxiv.org/pdf/2511.09124

*A-78 Ryan Babbush et al.、Exponential quantum speedup in simulating coupled classical oscillators、https://journals.aps.org/prx/pdf/10.1103/PhysRevX.13.041041

*A-79 Chi-Fang Anthony Chen et al.、Local minima in quantum systems、https://www.nature.com/articles/s41567-025-02781-4(https://arxiv.org/pdf/2309.16596)

*A-80 Scott Aaronson & Andris Ambainis、Forrelation: A Problem that Optimally Separates Quantum from

Classical Computing、https://arxiv.org/pdf/1411.5729

*A-81 Uma Girish & Rocco A. Servedio、Forrelation is Extremally Hard、https://arxiv.org/pdf/2508.02514

*A-82 Takashi Yamakawa & Mark Zhandry、Verifiable Quantum Advantage without Structure、https://arxiv.org/pdf/2204.02063

*A-83 Andrew M. Childs et al.、Exponential algorithmic speedup by quantum walk、https://arxiv.org/pdf/quant-ph/0209131

*A-84 Seth Lloyd et al.、Quantum algorithms for topological and geometric

analysis of data、https://www.nature.com/articles/ncomms10138.pdf

*A-85 Sean Hallgren、Polynomial-Time Quantum Algorithms for Pell’s

Equation and the Principal Ideal Problem、https://www.cse.psu.edu/~sjh26/pell.pdf

*A-86 Kiran S. Kedlaya、Quantum computation of zeta functions of curves、https://arxiv.org/pdf/math/0411623

*A-87 Sean Hallgren、Fast Quantum Algorithms for Computing the Unit Group and

Class Group of a Number Field、https://www.cse.psu.edu/~sjh26/unitgroup.pdf

*A-88 Wim van Dam & Igor E. Shparlinski、Classical and Quantum Algorithms for Exponential Congruences、https://link.springer.com/chapter/10.1007/978-3-540-89304-2_1

*A-89 Alexander Schmidhuber et al.、Quartic Quantum Speedups for Planted Inference、https://journals.aps.org/prx/pdf/10.1103/PhysRevX.15.021077

*A-90 Alexander Schmidhuber & Alexander Zlokapa、Quartic quantum speedups for community detection、https://arxiv.org/pdf/2510.08494

*A-91 Alexander S. Wein et al.、The Kikuchi Hierarchy and Tensor PCA、https://arxiv.org/pdf/1904.03858

*A-92 Wim van Dam et al.、Quantum Algorithms for some Hidden Shift Problems、https://epubs.siam.org/doi/10.1137/S009753970343141X

*A-93 Andrew M. Childs et al.、Constructing elliptic curve isogenies

in quantum subexponential time、https://arxiv.org/pdf/1012.4019

*A-94 Oded Regev、Quantum Computation and Lattice Problems、https://arxiv.org/pdf/cs/0304005

*A-95 Graham Kenny & Ganna Pogrebna、Quantum Thinking Can Help You Solve Complex Strategy Challenges、https://hbr.org/2025/11/quantum-thinking-can-help-you-solve-complex-strategy-challenges

・・・

*A-98 Satoki Tsuji et al.、GPU-Accelerated Fock Matrix Computation with Efficient Reduction、https://www.mdpi.com/2076-3417/15/9/4779/pdf?version=1745828604

・・・

*A-100 Ashish Joshi & Takahiko Koyama、Quantum Algorithm for Metabolic Network Analysis、https://www.biorxiv.org/content/10.1101/2025.10.26.684702v1.full.pdf

*A-101 松田史生 et al.、我が国の産業微生物研究の最前|代謝シミュレーションによる細胞内代謝のデザインと工学的応用、生物工学第92巻、2014年第11号、pp.593-597、https://www.sbj.or.jp/wp-content/uploads/file/sbj/9211/9211_tokushu_2.pdf

*A-102 戸谷吉博、フラックス解析のいろいろ、生物工学会誌 第99巻 第1号 36.2021、p.36、https://www.jstage.jst.go.jp/article/seibutsukogaku/99/1/99_99.1_36/_pdf

*A-103 https://metabolic-engineering.jp/page/research/2

*A-104 早川 龍 & 森前智行、量子計算量理論と量子アルゴリズム、電子情報通信学会誌 Vol. 104, No. 11, 2021、pp.1182-1188、https://www.yukawa.kyoto-u.ac.jp/wp-content/uploads/2021/12/f83e13cf47302c78837672df2a866183.pdf

*A-105 吉岡信行、物性物理のための誤り耐性量子計算、物性若手夏の学校テキスト 3, 298 (2025)、https://www.jstage.jst.go.jp/article/natsugaku/3/0/3_298/_pdf/-char/ja

*A-106 我妻航也 et al.、構造解析における有限要素法の線形ソルバーとしての量子特異値変換の適用性の検討、計算工学講演会論文集 Vol. 30 (2025 年 6 月)、https://confit-sfs.atlas.jp/customer/jsces30/abstract/C-06-02.pdf

*A-107 https://blog.google/technology/research/google-gesda-xprize-quantum-applications-finalists/

━━━━━━━━━━━━━━━━━━━━━━━━━━━━

*N-8 https://www.nqcc.ac.uk/insights-paper-the-convergence-of-healthcare-and-pharmaceuticals-with-quantum-computing/

*N-9 Yidong Zhou et al.、Quantum-machine-assisted drug discovery、https://www.nature.com/articles/s44386-025-00033-2.pdf

*N-10 Kendall Byler & Shahar Keinan、A Comparison of Small Molecule Generation Methods in Structure-Based Drug Design: Artificial Intelligence vs Quantum Computing、https://chemrxiv.org/engage/api-gateway/chemrxiv/assets/orp/resource/item/68ff88e4113cc7cfff6567fb/original/a-comparison-of-small-molecule-generation-methods-in-structure-based-drug-design-artificial-intelligence-vs-quantum-computing.pdf

*N-11 渡邉信久、バイオマテリアル基礎論 第三回 医薬品開発と結晶構造解析、https://www.nusr.nagoya-u.ac.jp/WatanabeLab/Lectures/Basics-BioMaterial-3.pdf

*N-12 Four ways to power-up AI for drug discovery、https://www.nature.com/articles/d41586-025-00602-5

*N-13 https://www.apheris.com/industries/aisb

*N-14 Kun Ming Goh、Quantum-Enhanced Generative Adversarial Networks: Comparative Analysis of Classical and Hybrid Quantum–Classical Generative Adversarial Networks、https://arxiv.org/pdf/2508.09209

*N-15 種谷望、量子敵対的生成ネットワークよる画像生成および画像処理アプリケーションの開発、https://www.ipa.go.jp/jinzai/mitou/target/2020/qv6pgp0000002nff-att/000089023.pdf